新智元报道

编辑:桃子 好困

【新智元导读】OpenAI撒钱了!找到BUG者,最高奖赏2万美金,当然了越狱不算。这才发布不久,已经有人想着靠它发家致富了。

ChatGPT正红的发紫,但存在不少的漏洞问题也引发许多人的担忧。

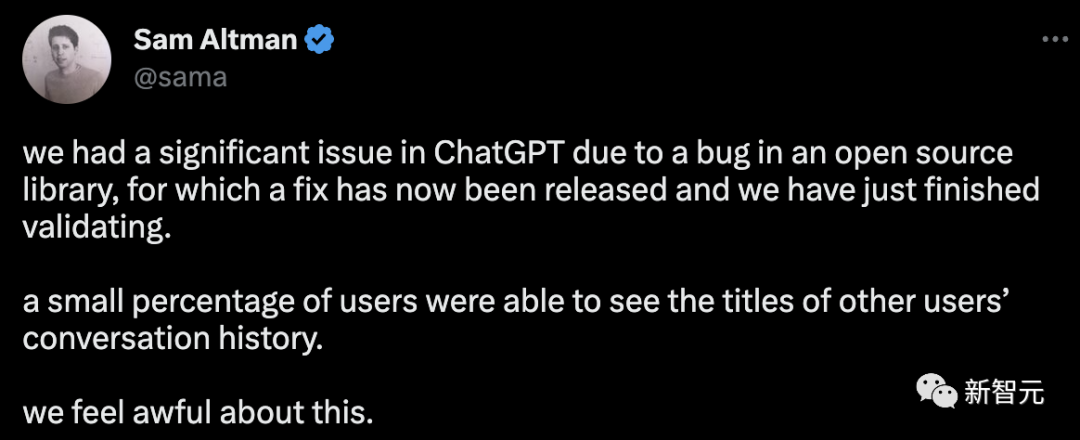

就比如上个月,ChatGPT出现了能够看到别人聊天记录的重大BUG。当时,OpenAI不得不将ChatGPT下线调查问题,把锅扔给了开源库的错误。

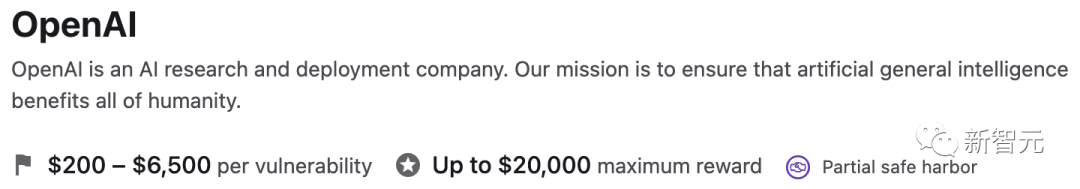

今天,OpenAI宣布了一个bug赏金计划,赏金从200美元到20000美元不等。

如果想要得到2万美金(近14万),那必定是OpenAI认定的「特殊发现」。

有网友最先举手,我发现了bug!ChatGPT限制3个小时只能25条信息。

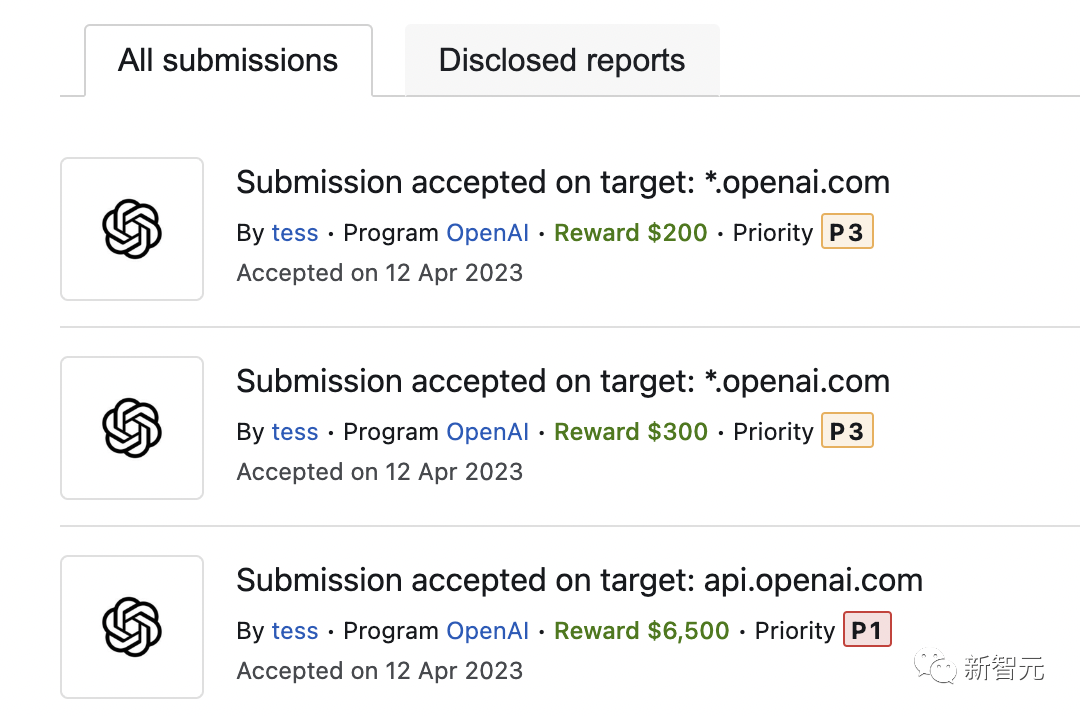

一发布,已经有一位名叫tess的开发者极力找出3个bug,拿到了7000美金。

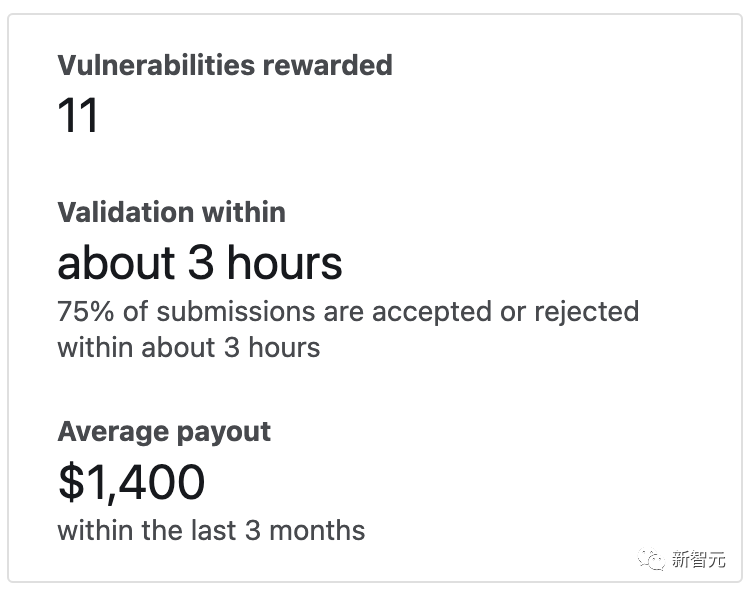

截至目前,已经有11人得到了悬赏。

做BUG猎人,拿2万美金

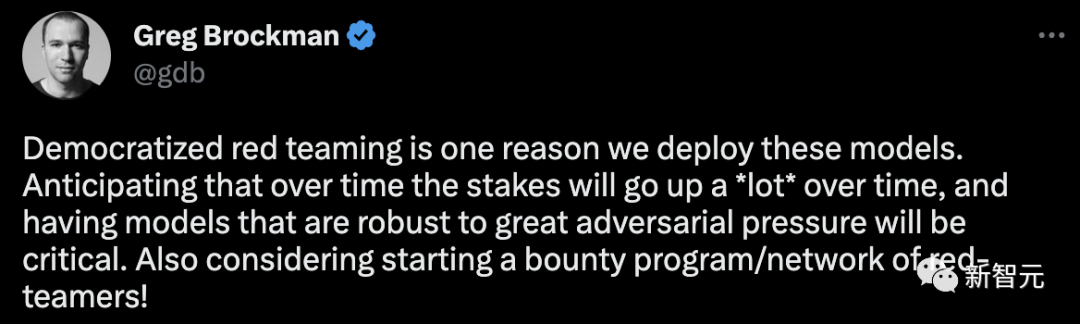

这一计划的推出并不令人意外。此前联合创始人Greg Brockman在推特上透露,OpenAI正考虑启动赏金计划/红队网,来检测薄弱环节。

推出这一计划的部分原因是OpenAI认为「透明度和协作」是发现技术漏洞的关键。

OpenAI的安全主管Matthew Knight在博客中称,

这一举措是我们致力于开发安全和先进人工智能的重要组成部分。在我们创造安全、可靠和值得信赖的技术和服务时,我们需要您的帮助。

这么丰厚的奖金,干脆做个全职的bug猎人吧。有网友表示,这不是很快就要成为百万富翁了。

ChatGPT面世以来,一些用户成功越狱,让其说脏话、写一些被禁止的政治话题,甚至是创建恶意软件。

重点来了,OpenAI强调:越狱行为不算,另外也不接受那些欺骗AI违反其自身规则的文本提示。

另一位网友一语点醒梦中人,发家致富之路没了。

还有人另辟蹊径:让ChatGPT-4去发现代码错误,这不钱就来了。

OpenAI指出,也不接受那些欺骗AI违反其自身规则的文本提示。此外,这个赏金计划也不接受有关ChatGPT产生错误信息的报告。

除非它们对服务产生直接可验证的安全影响,否则是不会奖励的。

OpenAI称,模型安全问题不适合纳入漏洞悬赏计划,因为它们不是可以直接修复的单个、离散的漏洞。

解决这些问题通常涉及大量研究和更广泛的方法。

到底什么不算模型安全问题,OpenAI也给列了一个具体范围:

不在范围内的安全问题示例:

- 越狱/安全绕过(例如DAN和相关提示)

- 让模型对你说坏话

- 让模型告诉你如何做坏事

- 让模型为你编写恶意代码

模型幻觉:

- 让模型假装做坏事

- 让模型假装给你提供秘密的答案

- 让模型假装成计算机并执行代码

OpenAI表示,这一计划在bug赏金平台Bugcrowd中进行,需要遵循一些详细规则。

其中最突出的点就是,OpenAI要求bug猎人在自己安全团队授权发布漏洞之前,一定要保密。

另外,OpenAI的机密数据是不可以的访问、修改,甚至是使用。

上榜大佬

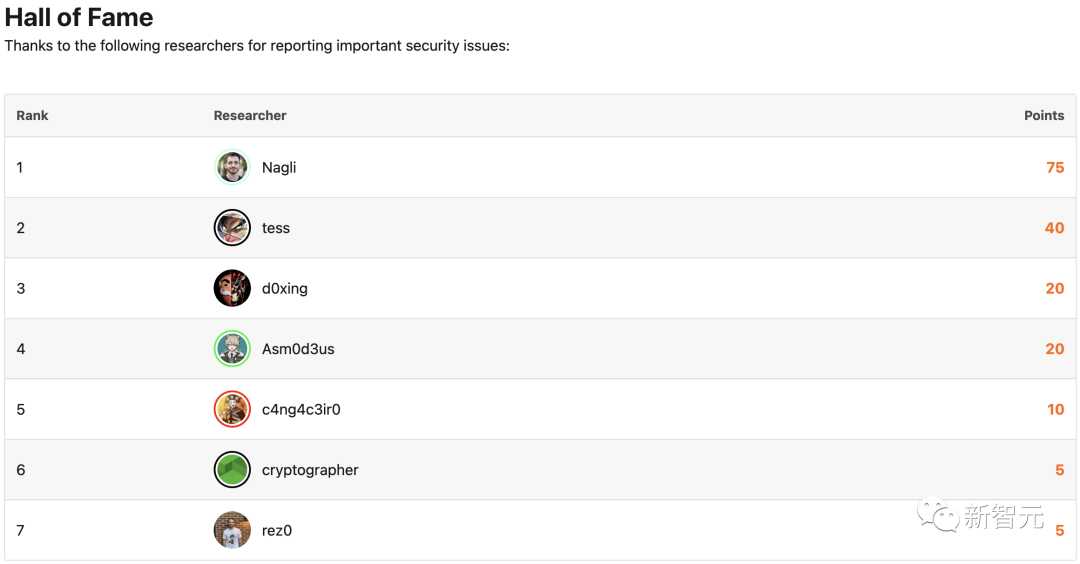

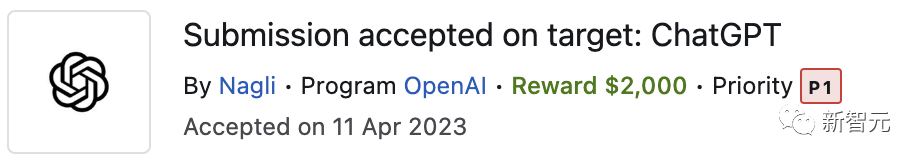

在Bugcrowd名人堂中,一个网络安全公司Shockwave Cloud的创始人Gal Nagli贡献最多。

在OpenAI今天发起这个倡议后,他发布推特举手赞成。

就在3月25日,OpenAI团队修复了他提出的一个bug。

这个漏洞叫「Web Cache Deception」,可以让攻击者有可能接管某人的账户,查看其聊天历史纪录,还能访问账单信息。

这不就巧了吗,许多用户报告自己能够看到别人的聊天记录的时间恰恰也在这个时候。

当时Sam Altman不得不亲自出面,在推特上解释,bug问题源于开源代码库中存在的一个错误,最终导致ChatGPT聊天历史泄露。

Gal Nagli详细介绍了自己如何发现这一漏洞的过程,

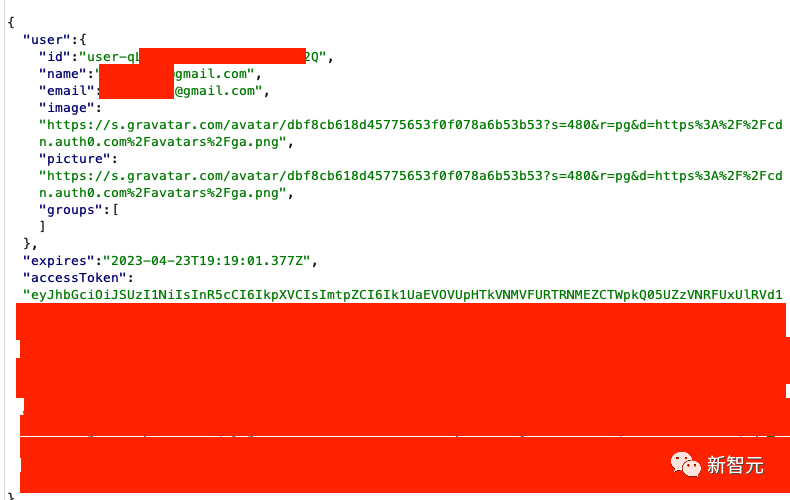

在他处理ChatGPT认证流程的请求时,一直在寻找可能泄露用户信息的任何异常情况。一个GET请求,直接引起了他的注意:

https://chat.openai[.]com/api/auth/session。

基本上,每当我们登录到ChatGPT时,这个工具就会获取包括电子邮件、姓名、图像和accessToken在内的信息。

而攻击者想要泄露这些信息,便可以在服务器中利用「Web Cache Deception」这一漏洞。

Nagli称这种手法自己曾在各种黑客比赛中见过很多次,甚至在许多人的博客中也有提到。

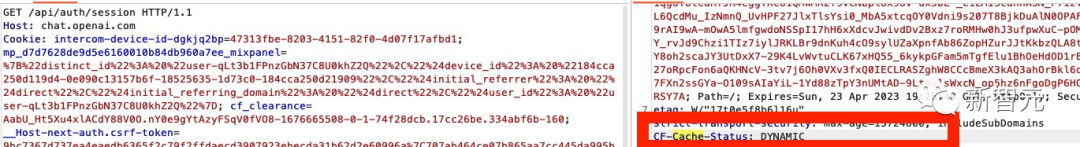

在高级视图中,这个漏洞非常简单,如果设法强制Load Balancer在特定路径上缓存请求,其他人便能够从缓存的响应中读取用户的敏感数据。在这种情况下,漏洞不会直接发生。

为了让这个漏洞发挥作用,需要让CF-Cache-Status响应确认一个缓存的HIT。这意味着它缓存了数据,并将为同一区域下一个请求提供服务。如果收到动态(DYNAMIC)响应,就不会缓存数据了。

Nagli分享了一个攻击流程:

-攻击者构造一个专用的.css路径,指向/api/auth/session端点。-攻击者分发链接(直接发送给受害者或公开发布)。-受害者访问合法链接。-响应被缓存。-攻击者收集JWT凭证。他提出的修复方案是,通过正则表达式(regex)手动指示Load Balancer不要捕获该端点。当然了,这也是OpenAI选择的修复方法。在这漏洞被修复后,Nagli还收到了OpenAI的表扬邮件。

在名人堂上统计中,Nagli已经赚到2500美金。

就在刚刚,Nagli又发现了3个不同严重程度的附加漏洞,并获得了300美金的奖励。

看到这么丰厚的赏金,想必许多人已经等不及了,快来一起找bug吧。

参考资料:https://openai.com/blog/bug-bounty-program

【版權聲明】

本文爲轉帖,原文鏈接如下,如有侵權,請聯繫我們,我們會及時刪除

原文鏈接:https://mp.weixin.qq.com/s/z8ApEUSJ0urTR2JKZAV0jA Tag: ChatGPT