Transformer Explainer:一种可视化工具,帮助新手快速了解Transformer

ChatGPT 是一个使用 Transformers 和强化学习的 AI 工具。

Transformer 是一种可以将西班牙语翻译成英语、生成图像、撰写博客甚至生成计算机代码的模型。

它们可用于地理学,生物学,甚至医学领域各种问题。

因此,如果你想在生成式人工智能领域保持领先地位,你需要了解 Transformer Explainer

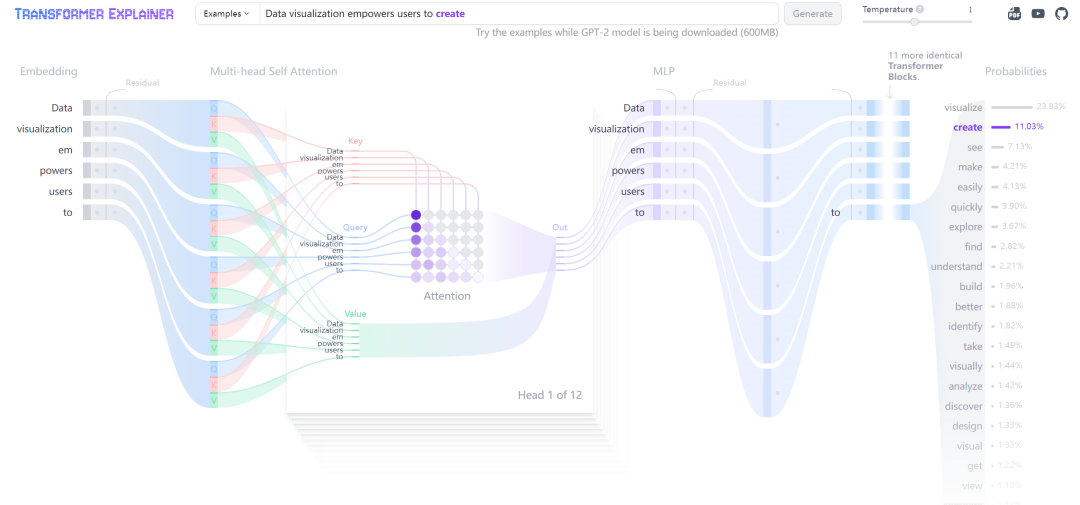

网页展示

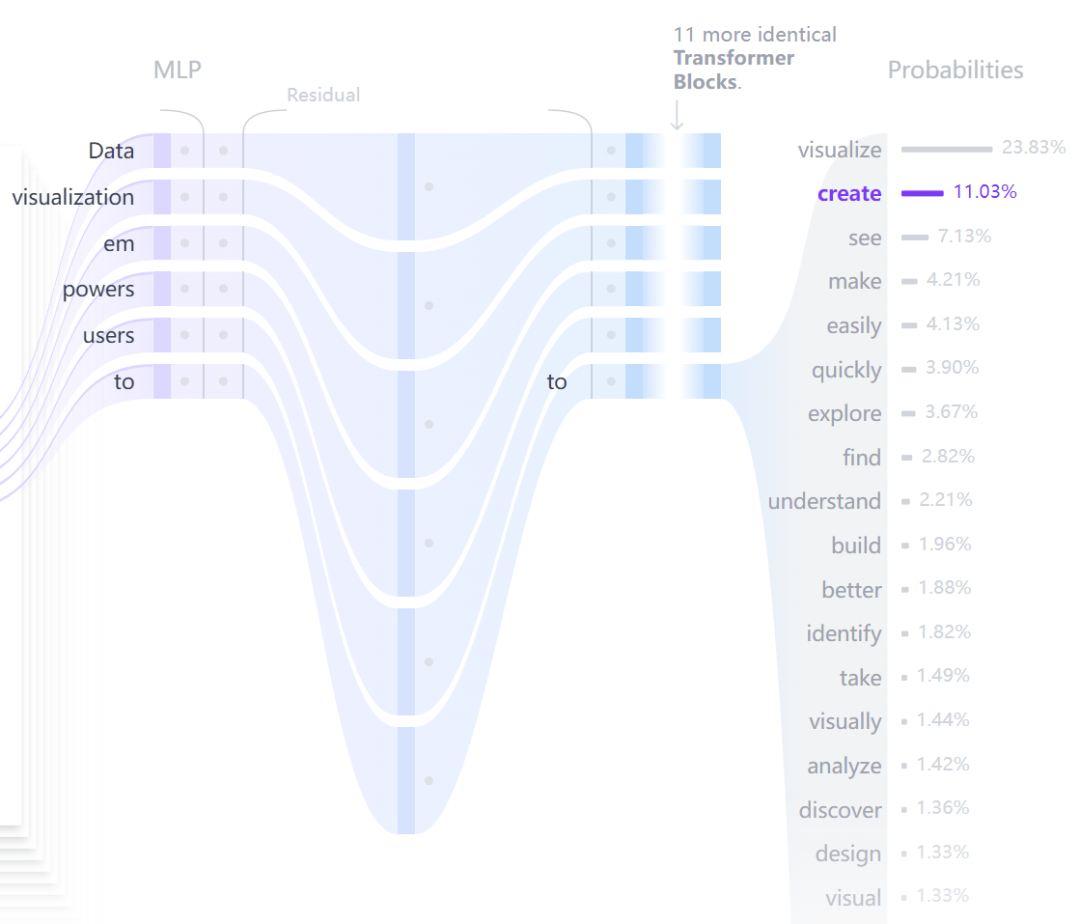

感谢佐治亚理工学院和 IBM 的一些杰出研究人员,我们现在拥有了一款出色的 Transformer 可视化工具。该工具让我们可以全面了解 Transformer 内部发生的情况。此工具的一个很棒的功能是,您可以试用他们提供的示例或创建自己的示例。执行此操作时,您会看到转换器架构内的所有更改。

全部可视化过程

全部可视化过程

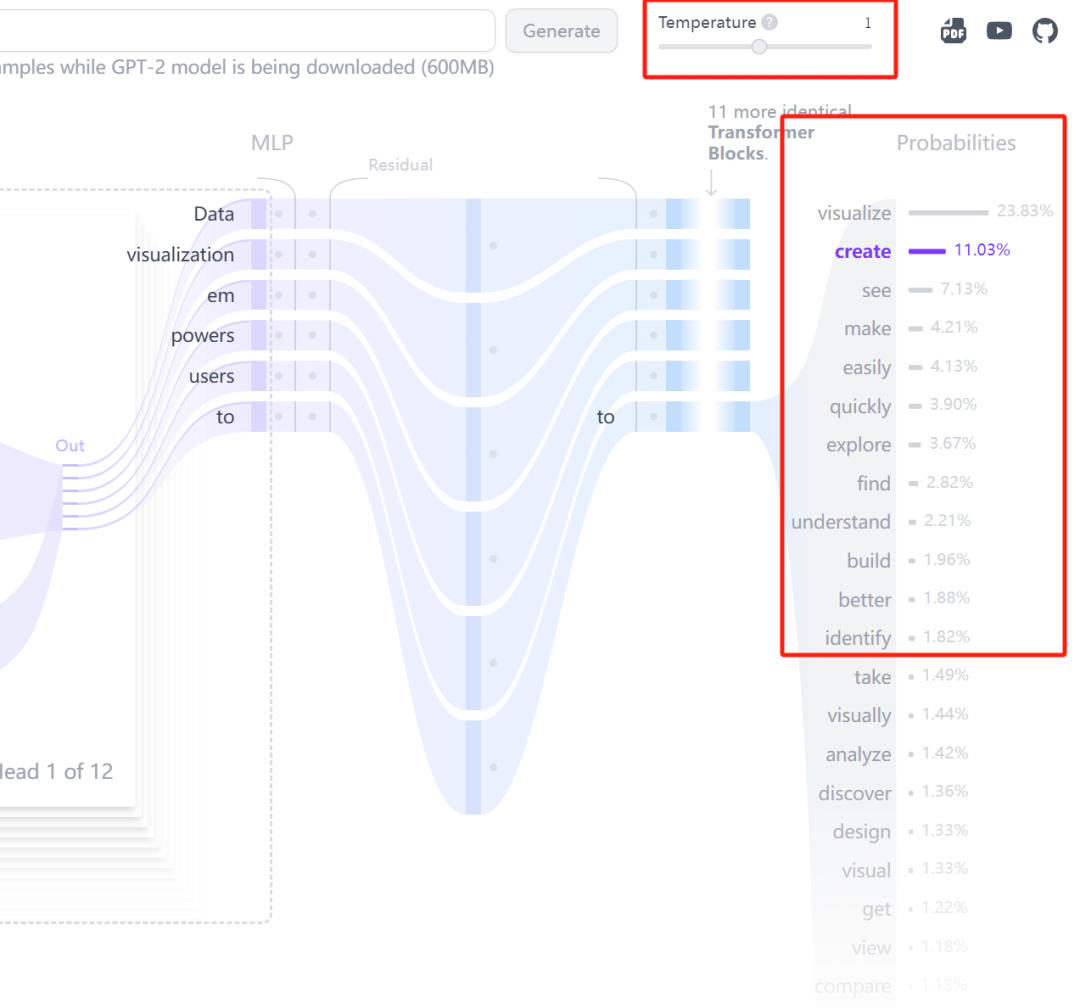

Temperature

TRANSFORMER EXPLAINER 的一个有趣功能是调整“温度”参数

这是什么?温度是控制 LLM 输出随机性的参数,它直接影响模型在生成文本时如何从可能的下一个单词中进行选择

如果将温度设置为 0.1,LLM 将始终生成最有可能的下一个单词,这对于回答问题等非常有用。但是,如果将温度设置为 1,LLM 将更有可能生成不太可能的下一个单词,这可能会产生更具创意的文本。

参数设置

参数设置

Embedding

让我们仔细看看 Transformer Explainer 中的“embeding”部分。这部分将向我们展示如何转换标记。那么,embeding中发生了什么?当输入文本时,它会通过四个步骤转换为最终的embeding。

例如,让我们以“在地学万事屋公众号学习地理学知识”这句话为例。当它被标记化时,它会被拆分成 [“在”、“地学”、“万事屋”、“公众号”、“学习”、“地理学”、“知识”] 这样的标记。然后,每个标记都会被赋予一个唯一的标识符。

然后,标记嵌入步骤开始。这会将每个单词转换为数值数据,有点像将单词转换为数字。这允许模型理解和捕捉不同标记在含义上的相似程度。

接下来,我们进行位置编码。

“地学万事屋公众号”与“地学公众号万事屋”。它们听起来很像,但意思却完全不同

我们为每个单词的嵌入添加一个特殊向量,以指示其在句子中的位置。这些向量经过精心设计,以便模型可以从中学习以理解单词的顺序。

Embedding介绍

Embedding介绍

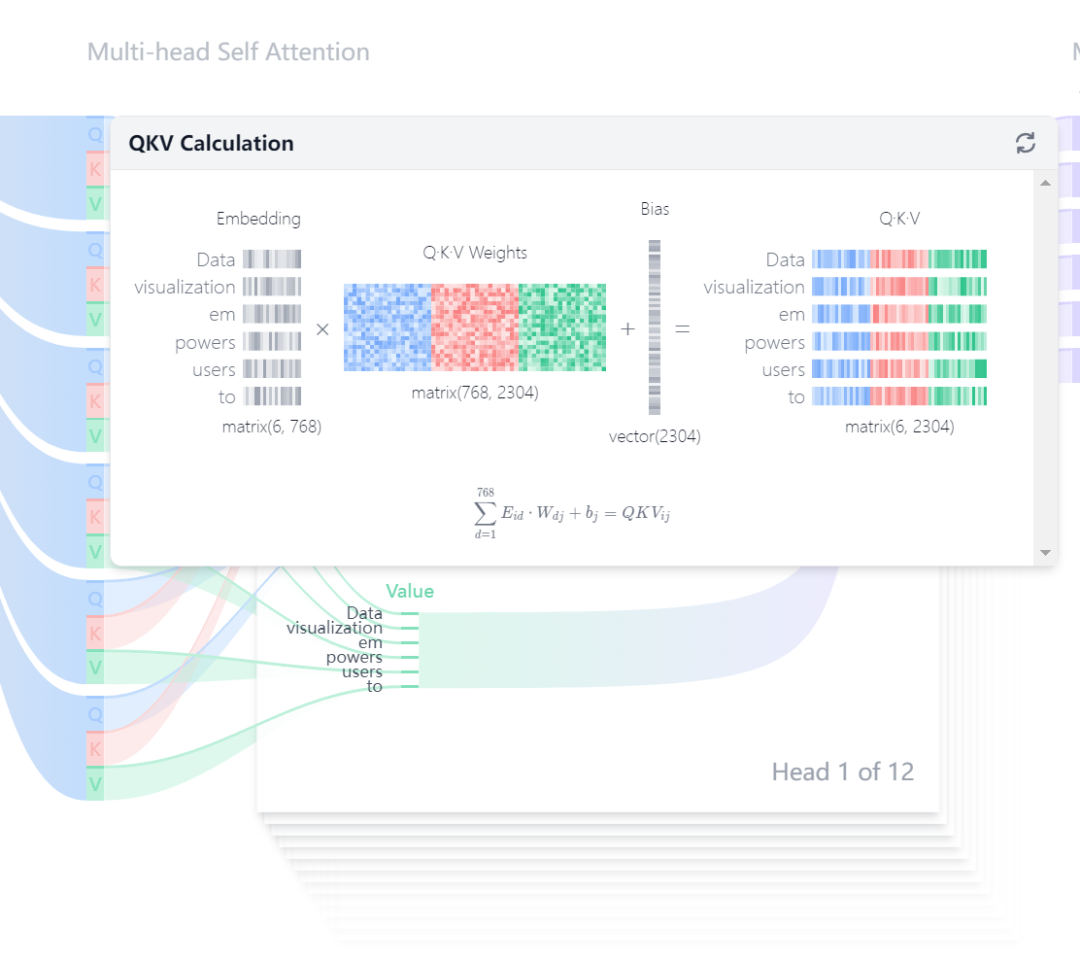

Multi-head Self Attention

然后,这种嵌入用于所谓的多头自注意力,它可以帮助模型识别标记之间的复杂关系和依赖关系,无论它们在句子中相距多远。从这个向量,我们计算出三个重要的输入:查询、键和值。这些允许模型根据当前标记的查询提供的上下文关注输入句子的不同部分。这意味着模型可以更加关注句子中任何时刻最重要的部分。

多头注意力图示

多头注意力图示

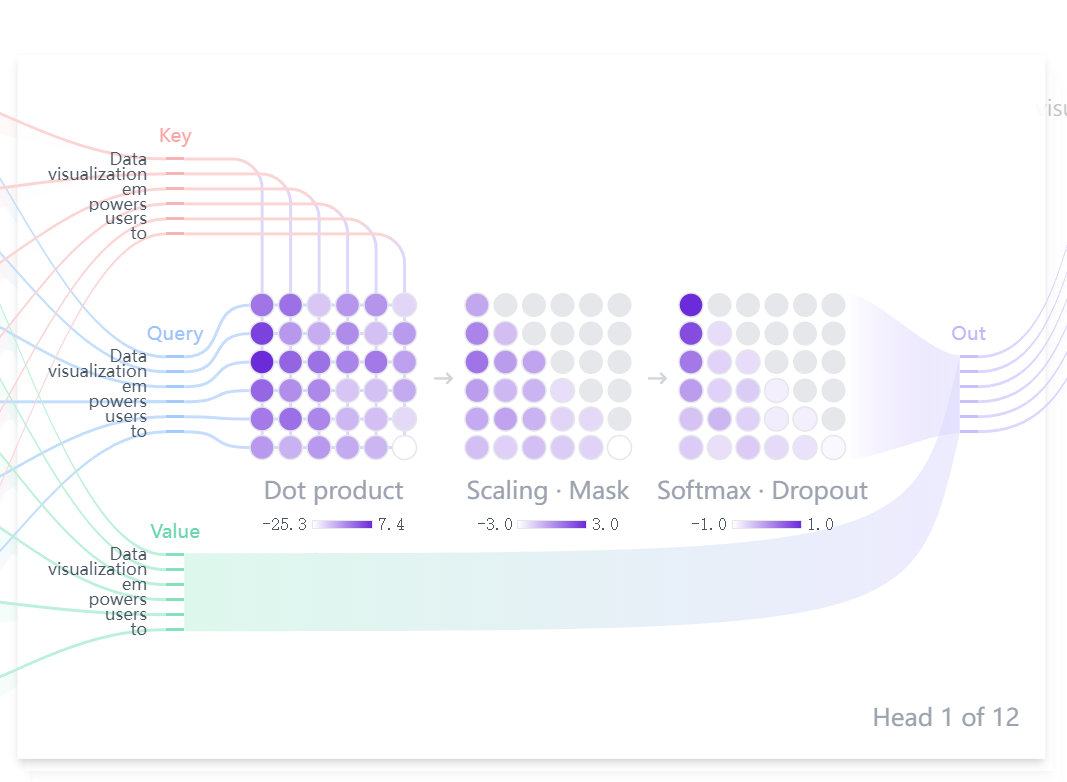

注意力分数决定了每个标记的值对“数据”的最终输出表示有多大的影响。对序列中的每个标记重复此过程,从而使模型能够捕获输入数据中的复杂关系和依赖关系。

注意力QKV图示

注意力QKV图示

注意力得分是通过计算“数据”查询与所有标记的键的点积来计算的。计算点积后,我们将 softmax 函数应用于这些得分,以将它们转换为注意力权重。此步骤确保权重总和为 1,从而允许将它们解释为概率。最后,我们使用从 softmax 步骤获得的注意力权重,通过计算所有标记的值 (V) 的加权和来计算“数据”的输出。

MLP和Dropout图示

MLP和Dropout图示

接下来,使用 dropout 来改善泛化并防止过度拟合,即在训练期间随机禁用一定比例的神经元。LayerNorm也用于稳定和加速深度神经网络的训练。它通过减去平均值并将其除以标准差来规范化层的输出。之后,使用模型学习的参数对输出进行缩放和移位。

感兴趣的同学可以自己点进网站进行交互。

网站:https://poloclub.github.io/transformer-explainer/

【版權聲明】

本文爲轉帖,原文鏈接如下,如有侵權,請聯繫我們,我們會及時刪除

原文鏈接:https://mp.weixin.qq.com/s/DinyCD0VWURFflMbF3Z0jw Tag: ChatGPT 人工智能 Transformer